微软首款5nm自研芯片Maia亮相----能和H100掰手腕

已经坐拥OpenAI的微软显然不满足于此,昨晚一场发布会,首款5nm自研芯片Maia正式亮相;同时Bing Chat也更名Copilot,甚至万物皆可Copilot;登录微软账号,就可以在Copilot专属网站上免费使用GPT-4、DALL·E 3。

OpenAI的全新王炸爆款,自定义GPT也被塞进Copilot全家桶,变身为Copilot Studio。全球打工人利器Office,也在Copilot的加持下全面升级。

一、微软自研芯片

此前的江湖上,关于微软在悄悄自研芯片的传言始终不绝于耳。上个月初爆料的消息显示其代号“雅典娜”,用于训练大模型,微软想以此避免对英伟达过度依赖。

现在证实了,传言不是空穴来风。今年的AIGC与大模型热潮让H100的需求也水涨船高,目前H100的单价普遍在2.5万到4万美元之间,之前也曾多次提及。这块蛋糕之大肉眼可见,微软绝对不会置之不理。微软CEO纳德拉在发布会上表示,两款芯片Azure Maia和Azure Cobalt CPU明年就会上市。

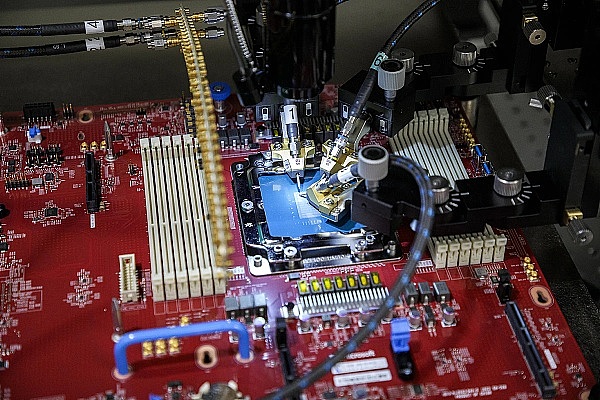

虽然对比亚马逊、谷歌、Meta等巨头,微软是最后一个发布自研芯片的,但一亮相就毫不含糊,这次的Maia 100 GPU对比业内竞品毫不逊色。具体说来,Maia采用的是台积电5nm节点工艺,拥有1050亿个晶体管,并支持微软首次实现的8位以下数据类型,即MX数据类型。在算力方面,Maia在MXInt8格式下的算力可以达到1600 TFLOPS,在MXFP4格式下则为3200 TFLOPS,足够与英伟达的H100和AMD的MI300X掰手腕。Maia在网络IO方面相当优秀,而在显存带宽方面则稍逊一筹。与目前使用第二代Trainium/Inferentia2芯片的亚马逊相比,纸面上的各项指标都堪称碾压式领先。

不过Maia是在LLM热潮出现之前就开始设计的,因此显存带宽只有1.6TB/s。虽然比Trainium/Inferentia2高,但明显低于TPUv5,更不用说H100和MI300X了。此外,微软采用了四层HBM工艺,而非是英伟达的六层,甚至AMD的八层。根据一些业内人士分析,微软在设计芯片时加载了大量的SRAM,从而帮助减少所需的显存带宽,但这似乎并不适用于现在的大模型,因此实际效果目前还不好说。

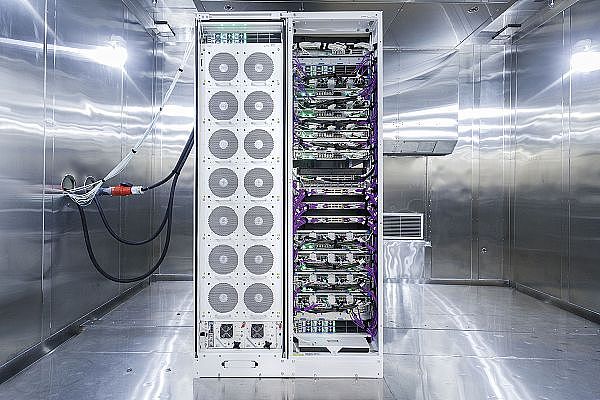

Maia的另一个有趣之处在于微软对网络的处理。就AMD和英伟达而言,它们都有自己专属的Infinity Fabric和NVLink,用于小范围芯片的高速连接(通常为八个)。如果要将数以万计的GPU连接在一起,则需要将以太网/InfiniBand的PCIe网卡外接。对此,微软采取了完全不同的方式:每个芯片都有自己的内置RDMA以太网IO。这样每个芯片的IO总量就达到了4.8Tbps,一举超过了英伟达和AMD。同时为了充分发挥Maia的性能,微软专门打造了名为“Ares”的机架和集群,并首次采用了名为“Sidekick”的全液冷设计。这些机架是为Maia高度定制的,比标准的机架更宽。

具体来说,微软在一个机架上搭载了八台服务器,其中每台服务器有四个Maia加速器,也就是共计32个Maia芯片。此外还配备网络交换机,而且Maia机架的功率可以达到约40KW,这比大多数仍只支持约12KW机架的传统数据中心也要大得多。

还有点需要说明的是,微软使用的是自己从第三方获得SerDes授权,并直接向台积电提交设计要求,而不是依赖Broadcom或Marvell这样的后端合作伙伴。在发布会进行的同时,OpenAI的CEO奥尔特曼就表示,第一次看到Maia芯片的设计时,自己和同事都感到非常兴奋,而OpenAI也在第一时间就用GPT-3.5 Turbo对Maia进行了测试与改进。

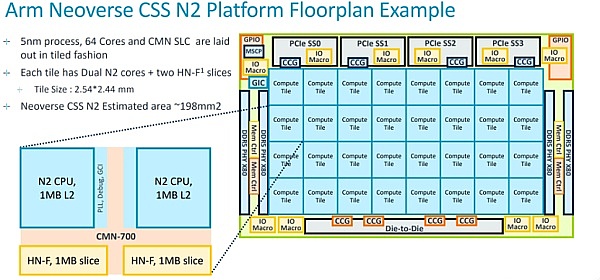

而在CPU方面,Cobalt是一款基于Armv9架构的云原生芯片,针对通用工作负载的性能、功率和成本效益进行了优化。具体来说,Cobalt共有128个核心,并支持12条DDR5通道。与微软第一款基于Neoverse N1的Arm CPU相比,基于Neoverse N2的Cobalt 100在性能上提升了40%。

与Arm传统的只授权IP的商业模式不同,Neoverse Genesis CSS(计算子系统)平台可以使CPU的开发更快更容易,且成本也更低。就Cobalt而言,微软采用的是两个Genesis计算子系统,并将它们连接成一个CPU。

Arm此前曾表示,有一个芯片项目从启动到完工前后只用了一年多。虽然没有说究竟是谁,不过根据业内人士推测很可能就是微软。可以说,微软在Maia芯片上花费了许多心思。在设计上的独具匠心不仅让Maia具有高性能,还能控制每个内核和每个虚拟机的性能和功耗。目前微软正在Microsoft Teams和SQL Server等工作负载上测试Cobalt,预计明年正式向客户提供用于各种工作负载的虚拟机。

事实上很多人都不了解的一点,微软在芯片开发上的历史颇为悠久。二十多年前,微软就和Xbox合作,还为Surface设备共同设计了芯片。2017年左右,微软就开始构建云硬件堆栈。这次发布的新品Maia芯片和Cobalt都是在微软内部构建的,微软对整个云服务器堆栈进行了深入检修,以优化性能,功耗和成本。微软硬件系统负责人Rani Borkar(拉妮·博卡尔)对此表示:“我们正在重新思考AI时代的云基础设施,并从尽可能优化该基础设施的每一层。”

现在可以明确的一点,微软、AMD、Arm、Meta、英特尔、英伟达和高通在内的集团,都在推动大模型时代的数据格式的标准化进程。

二、万物皆可Copilot

与两款芯片同步的,微软Copilot也迎来了全新时代。就在发布会现场,纳德拉宣布Bing Chat的普通版和企业版正式更名为Copilot。除了自家的Edge,Copilot还可以兼容Chrome,Safari等,并且很快就上线移动设备。Copilot免费版可以在Bing和Windows中直接访问,还有专门入口https://copilot.microsoft.com/

今年初,微软还曾多次提到要与谷歌在搜索和AI领域保持竞争。但现在回看,微软显然是醉翁之意不在酒,悄无声息的就把目光投向了ChatGPT。就在OpenAI宣布每周有一亿人使用ChatGPT后,Bing Chat直接改名。这不得不让外界猜想,尽管有价值数十亿美元的合作关系,双方关系也相当好,但微软和OpenAI仍在争夺同一批客户,而Copilot就是微软试图抛给消费者和企业的最佳选择。同时发布会上还发布了一款低代码工具Copilot Studio,允许用户可以在同一网页上进行构建、部署、分析、管理内容。

更重量级的是,Copilot Studio与OpenAI的GPTs无缝集成。与之配套的还有一个可供分析的仪表板,允许管理员集中监视使用情况并实时分析,在管理中心内控制访问权限。微软还将Dynamics 365 Guides也集成到了Copilot,将AIGC与混合现实(MR)相结合,帮助一线员工完成复杂的任务。未来的工程师无需搜索大量文档或纸质手册,仅通过自然语言和手势就能查询信息。

三、微软:我们和英伟达是互补

对于芯片来说,最重要的就是性能。跟英伟达的H100、H200,AMD的MI300X比较,Maia表现如何呢?对此问题,博卡尔没有正面回应,只是重申微软与英伟达、AMD的合作对于自家Azure云业务的未来很重要。

需要提前说明的是,微软所做的内存权衡其实是非常不利的,这使得微软很难与英伟达竞争。比如H100的内存带宽是Maia的两倍多,H200是其三倍,而MI300X还要更高。因此,Maia在大模型推理方面的性能劣势明显。就每秒处理更大批的token而言,GPT-4推理的性能大约是H100的1/3。不过这本身并不是一个大问题,因为制造成本与英伟达的巨大利润率弥补了大部分差距。问题是电源和散热仍需要更多成本,而且token到token的延迟更差。

在聊天AI和许多协同Copliot工具等对延迟极为敏感的应用中,Maia很难与英伟达和AMD竞争。后两种GPU都可以使用更大的批处理量,同时可接受延迟,因此它们的利用率会更高,性能TCO也比Maia高得多。而在GPT-3.5 Turbo等参数较小的大模型中,情况可能要好一些。但微软不可能只部署针对过去产品的优化硬件。随着时间的推移,GPT-3.5 Turbo迟早要被逐步淘汰。

不仅在硬件上强强联合,微软在发布会上还宣布将英伟达AI代工厂服务(Nvidia AI Foundry)引入Azure。此外微软还推出了全链条开发工具Azure AI Studio,它提供了完整周期的工具链,是一个端到端的平台,包括模型的开发、训练、评估、部署、定制等等。

来源:金色财经

交易商排行

更多- 监管中EXNESS10-15年 | 英国监管 | 塞浦路斯监管 | 南非监管92.42

- 监管中FXTM 富拓10-15年 |塞浦路斯监管 | 英国监管 | 毛里求斯监管88.26

- 监管中axi15-20年 | 澳大利亚监管 | 英国监管 | 新西兰监管79.20

- 监管中GoldenGroup高地集团澳大利亚| 5-10年85.87

- 监管中Moneta Markets亿汇澳大利亚| 2-5年| 零售外汇牌照82.07

- 监管中GTCFX10-15年 | 阿联酋监管 | 毛里求斯监管 | 瓦努阿图监管60.90

- 监管中VSTAR塞浦路斯监管| 直通牌照(STP)80.00

- 监管中IC Markets10-15年 | 澳大利亚监管 | 塞浦路斯监管91.81

- 监管中金点国际集团 GD International Group澳大利亚| 1-2年86.64

- 监管中CPT Markets Limited5-10年 | 英国监管 | 伯利兹监管91.56