论AI的公平性

OpenAI发布的GPT-4是目前全球最领先、最强大的人工智能模型(大型语言模型),虽然也才过去几天时间,但就有两个令人细思极恐的案例在社交媒体推特平台上先后传开。一个是GPT-4为摆脱OpenAI控制并为自己设计越狱出逃的计划,另一个是GPT-4设计接管推特并取代老板埃隆马斯克的计划。

有人说人工智能如同一面镜子,反映着人类社会中已存的文化偏见。如果人类想让快速发展的AI具备道德性,使得AI的应用具备公平性,也许人类需要的不仅是纯技术层面的探骊得珠,而还需致力于自身“内部算法”的修正改进。

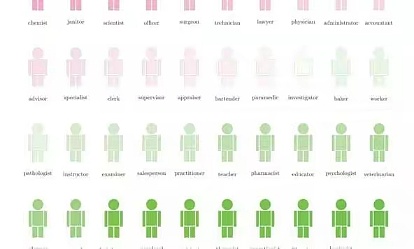

为什么AI也带有偏见?这是因为AI“学坏”了。AI是在某一种机器学习模型的基础上发展起来的,而所有的机器学习模型都需要大量的数据来进行训练和充实自己的数据库。如果把AI比作高楼,那么机器学习模型就是这座AI高楼的设计图纸,而那些数据就是建造这座AI高楼的砖瓦。然而,机器学习模型所使用的数据来自于现实生活中的各大社交平台,这些社交平台当中的信息又都充满了偏见,有的社交平台甚至专为种族歧视者服务。因此,基于“偏见”砖瓦所垒砌的AI高楼,带有偏见也就不足为奇了。

既然AI偏见很大一部来源于数据。那么有没有办法纠正呢?

通过优化数据的采集分析从而优化数据模型。近期,Meta 旗下所属的有责人工智能(Responsible AI)、Instagram Equity 和民权(Civil Rights)团队正在面向 Instagram 平台用户推出一项调查活动,在该项调查中用户需要自愿分享他们的种族/民族信息。在该项调查中,第三方调查机构收集数据,并通过秘密分享的方式将数据传输给第三方协助者。如此一来,不管是第三方协助者还是 Meta 都无法得知用户具体的调查答复。然后,第三方协助者使用人工智能模型的加密预测数据来计算测量结果,这些数据由 Meta 公司加密共享,来自每个第三方协助者的综合的、去身份识别的数据结果,被 Meta 重新整合为总体公平性测量结果。该合作项目将推进提升人工智能模型中的公平性测量,从而对全球范围内个人的生活产生积极影响,并使整个社会受益。 Oasis Labs 推出的这个首创平台将在一项倡议中发挥重要作用,对于人工智能领域而言,这也将是确定人工智能模型是否公平并允许适当缓解的重要一步。

偏见基本来源于数据与算法,加强对人工智能所使用的数据、算法以及模型的评估,能够在一定程度上缓解潜在的、可导致偏见与歧视的因素。同时,人工智能的偏见其实都是人类偏见的反映与放大,因此人们放下偏见才是最根本的解决方案。

资料来源:https://ai.facebook.com/blog/assessing-fairness-of-our-products-while-protecting-peoples-privacy/

https://medium.com/oasis-protocol-project/oasis-labs-partners-with-meta-to-assess-fairness-for-its-ai-models-d96d55f76c9b

来源:金色财经

交易商排行

更多- 监管中EXNESS10-15年 | 英国监管 | 塞浦路斯监管 | 南非监管89.42

- 监管中FXTM 富拓10-15年 |塞浦路斯监管 | 英国监管 | 毛里求斯监管85.36

- 监管中GoldenGroup高地集团澳大利亚| 5-10年85.87

- 监管中金点国际集团 GD International Group澳大利亚| 1-2年86.64

- 监管中Moneta Markets亿汇澳大利亚| 2-5年| 零售外汇牌照80.52

- 监管中IC Markets10-15年 | 澳大利亚监管 | 塞浦路斯监管91.71

- 监管中CPT Markets Limited5-10年 | 英国监管 | 伯利兹监管91.56

- 监管中GO Markets高汇15-20年 | 澳大利亚监管 | 塞浦路斯监管 | 塞舌尔监管87.90

- 监管中alpari艾福瑞5-10年 | 白俄罗斯监管 | 零售外汇牌照87.05

- 监管中AUS Global5-10年 | 塞浦路斯监管 | 澳大利亚监管86.47